1. 引言

1.1 Web Audio API 简介

Web Audio API 是一项强大的浏览器技术,它使我们能够以程序化的方式处理和分析音频数据。通过这个 API,我们可以在浏览器中创建各种音频应用,从简单的音频播放器到复杂的音频处理和可视化工具。Web Audio API 提供了一组强大的接口,使得在 Web 中处理音频变得更加容易。

这个 API 的核心是 AudioContext 对象,它代表了音频处理的上下文环境。在这个环境中,我们可以创建各种音频节点,连接它们,以及实现各种音频效果。其中,AnalyserNode 是一个特别有用的节点,它允许我们实时分析音频数据,为我们的应用增加一些炫酷的可视化效果。

1.2 目标:实现一个实时音频可视化效果

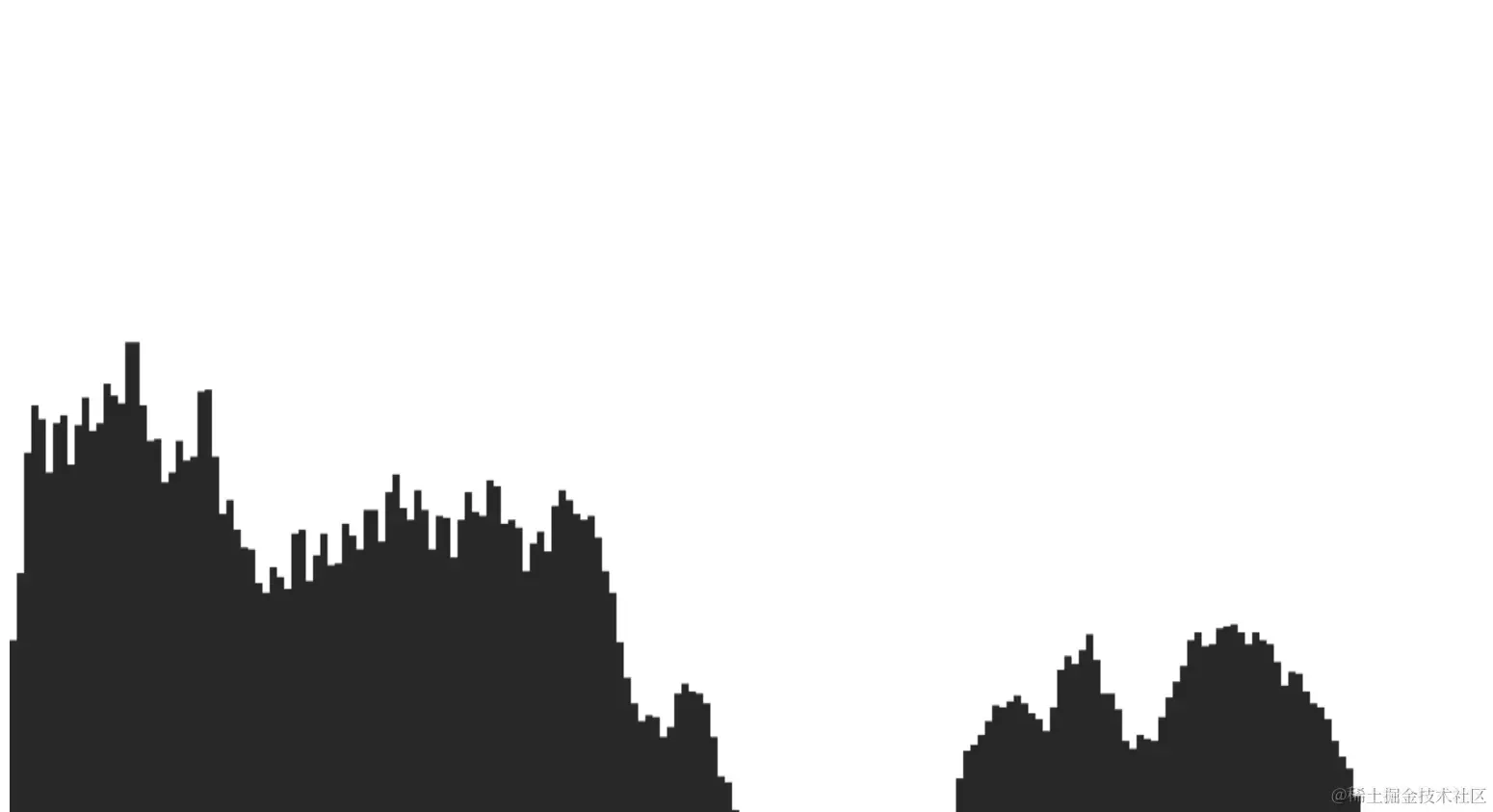

本文的目标是通过使用 Web Audio API,实现一个实时音频可视化效果。我们将使用浏览器提供的 getUserMedia 方法获取用户的麦克风权限,将麦克风输入的音频数据通过 AnalyserNode 进行分析,并通过 Canvas 绘制出实时的音频频谱图。这个项目不仅有助于理解 Web Audio API 的基本用法,还将为你提供创建其他音频应用的基础。

1.3 文章概述

文章将分为以下几个主要部分:

-

准备工作: 在这一部分,我们将介绍如何设置 Canvas 元素和 2D 渲染上下文,以及初始化 Canvas 大小。同时,我们将创建并初始化

AudioContext对象,为我们的音频可视化应用做好准备。 -

获取音频数据: 探讨如何使用

getUserMedia获取用户麦克风权限,创建MediaStreamSource并连接到AudioContext,以及如何初始化数组以存储分析后的音频数据。 -

实时音频可视化: 在这一部分,我们将创建一个动画循环,以实现实时更新画布。我们将详细解释如何获取音频数据并更新数组,以及如何使用 Canvas 绘制频谱图。

-

代码分析: 对实现的代码进行详细解释,逐行分析每个功能的实现原理和作用。我们将强调关键代码段的作用和重要性。

-

优化与扩展: 探讨可能的优化策略,以提高性能。我们还将讨论如何扩展应用,例如添加音频控制按钮或改变可视化效果。

-

结论: 总结所学到的关键知识点,并提供读者自行尝试的建议和资源链接。

-

参考资料: 提供 Web Audio API 文档、MDN Web Docs 相关文章以及其他相关资源链接,供读者进一步深入学习。

2. 准备工作

在开始实现我们的实时音频可视化效果之前,我们需要进行一些准备工作。这涉及到设置 Canvas 元素和 2D 渲染上下文,以及创建和初始化 Web Audio API 的 AudioContext 对象。

2.1 Canvas 元素和 2D 渲染上下文

HTML 结构

首先,我们需要在 HTML 中添加一个 <canvas> 元素,用于绘制音频可视化效果。在你的 HTML 文件中,添加如下代码:

1<!DOCTYPE html>

2<html lang="en">

3<head>

4 <meta charset="UTF-8">

5 <meta name="viewport" content="width=device-width, initial-scale=1.0">

6 <title>Real-time Audio Visualization</title>

7</head>

8<body>

9 <canvas id="audioCanvas"></canvas>

10 <script src="main.js"></script>

11</body>

12</html>

这个简单的 HTML 结构包含一个 Canvas 元素和一个引用 JavaScript 文件的 <script> 标签。我们将在 JavaScript 文件中编写我们的音频可视化代码。

Canvas 初始化

在 JavaScript 文件中,我们首先获取 <canvas> 元素的引用,并创建一个 2D 渲染上下文:

1const canvas = document.getElementById("audioCanvas");

2const ctx = canvas.getContext("2d");

接下来,我们需要确保 Canvas 元素的大小适应窗口大小,并且考虑到屏幕的 devicePixelRatio,以提高绘图的清晰度。为此,我们创建一个初始化函数:

1function initCanvas() {

2 canvas.width = window.innerWidth * devicePixelRatio;

3 canvas.height = (window.innerHeight / 2) * devicePixelRatio;

4}

在这个函数中,我们使用 window.innerWidth 和 window.innerHeight 获取窗口的宽度和高度,并乘以 devicePixelRatio 来适应屏幕像素密度。这样,我们就确保 Canvas 的大小与窗口一致,而且在 Retina 屏幕上也能够得到清晰的绘图效果。

最后,在代码的最开始调用这个初始化函数:

1initCanvas();

这样,我们就完成了 Canvas 元素的设置和初始化,为后续的音频可视化效果做好了准备。

2.2 音频上下文(AudioContext)的创建和初始化

Web Audio API 简介

Web Audio API 是现代浏览器中用于处理和分析音频数据的 JavaScript 接口。它提供了一套丰富的功能,允许我们在浏览器中创建和控制音频流。在 Web Audio API 中,AudioContext 对象是一个核心组件,代表音频处理的上下文环境。

AudioContext 对象的创建

让我们开始创建和初始化 AudioContext 对象。在我们的 JavaScript 文件中,添加以下代码:

1

2const audioContext = new (window.AudioContext || window.webkitAudioContext)();

上述代码首先检查浏览器是否支持标准的 AudioContext,如果不支持则回退到使用供应商前缀的版本。这样,我们就创建了一个 audioContext 对象,它将成为我们处理音频的环境。

1

2function initAudioContext() {

3 if (!audioContext) {

4 console.error("Web Audio API is not supported in this browser");

5 return;

6 }

7

8

9}

10

11

12initAudioContext();

在 initAudioContext 函数中,我们可以添加更多的初始化操作,例如检查浏览器是否支持 Web Audio API,或者设置一些默认参数。这样,我们就完成了音频上下文的创建和初始化,为后续的音频处理做好了准备。

在接下来的部分中,我们将深入探讨如何获取音频数据并实现实时音频可视化效果。

3. 获取音频数据

在这一部分,我们将详细介绍如何获取音频数据以进行实时音频可视化。我们将使用 WebRTC 提供的 getUserMedia 方法获取用户的麦克风权限,创建 MediaStreamSource 并将其连接到我们之前创建的 AudioContext。接着,我们将创建一个 AnalyserNode 对象,用于处理音频数据,并初始化一个数组以存储分析后的数据。

3.1 使用 getUserMedia 获取用户麦克风权限

WebRTC 和 getUserMedia

WebRTC(Web Real-Time Communication)是一组浏览器 API,用于实现实时通信功能,包括音频和视频传输。其中,getUserMedia 是 WebRTC 提供的一个重要方法,用于从用户的摄像头或麦克风获取媒体流。

让我们开始使用 getUserMedia 获取用户麦克风的权限:

1

2navigator.mediaDevices.getUserMedia({ audio: true })

3 .then((stream) => {

4

5 })

6 .catch((error) => {

7 console.error('Error accessing microphone:', error);

8 });

这段代码通过 navigator.mediaDevices.getUserMedia({ audio: true }) 请求用户麦克风的权限。如果用户同意,then 部分将获取到的音频流数据作为参数传递给回调函数。如果用户拒绝或发生错误,catch 部分将捕获并输出错误信息。

用户授权和错误处理

在实际应用中,我们可能需要向用户解释为何需要访问麦克风,并根据用户的选择进行不同的处理。例如,我们可以显示一个提示框来说明我们的应用将使用麦克风进行实时音频可视化。

1function requestMicrophonePermission() {

2 return new Promise((resolve, reject) => {

3 const permissions = { audio: true };

4

5 navigator.mediaDevices.getUserMedia(permissions)

6 .then((stream) => {

7

8 resolve(stream);

9 })

10 .catch((error) => {

11

12 reject(error);

13 });

14 });

15}

16

17

18requestMicrophonePermission()

19 .then((stream) => {

20

21 })

22 .catch((error) => {

23 console.error('Error accessing microphone:', error);

24 });

通过封装 getUserMedia 的调用为一个 Promise,我们可以更好地处理用户的授权选择。在 then 中,我们处理用户同意授权的情况,而在 catch 中,我们处理用户拒绝授权或发生错误的情况。

3.2 创建 MediaStreamSource 并连接到 AudioContext

MediaStreamSource 的创建和连接

一旦我们获取到音频流数据,接下来的步骤是将其连接到我们的 AudioContext。我们需要创建一个 MediaStreamSource 对象,该对象代表着音频流的源。

1

2requestMicrophonePermission()

3 .then((stream) => {

4

5 const source = audioContext.createMediaStreamSource(stream);

6

7

8 source.connect(audioContext.destination);

9 })

10 .catch((error) => {

11 console.error('Error accessing microphone:', error);

12 });

在这段代码中,我们使用 audioContext.createMediaStreamSource(stream) 创建了一个 MediaStreamSource,将其连接到了 audioContext.destination。这样,音频流就被成功地导入到了我们的音频上下文中。

同样的,如果你想获取来自播放视频或者音乐的可视化效果,使用audioContext中对应的其他方法,比如createMediaElementSource。

3.3 创建 AnalyserNode 对象用于处理音频数据

AnalyserNode 的作用和基本设置

现在我们已经将音频流连接到了 AudioContext,接下来我们将创建一个用于处理音频数据的 AnalyserNode 对象。

1

2requestMicrophonePermission()

3 .then((stream) => {

4

5 const source = audioContext.createMediaStreamSource(stream);

6

7

8 const analyser = audioContext.createAnalyser();

9

10

11 source.connect(analyser);

12 analyser.connect(audioContext.destination);

13 })

14 .catch((error) => {

15 console.error('Error accessing microphone:', error);

16 });

AnalyserNode 允许我们实时分析音频数据。我们将其连接到 MediaStreamSource,并将 AnalyserNode 连接到 audioContext.destination,以确保音频流能够正常播放。

初始化 AnalyserNode 的参数

在使用 AnalyserNode 之前,我们需要对其进行一些基本的设置

,以满足我们的可视化需求。

1

2requestMicrophonePermission()

3 .then((stream) => {

4

5 const source = audioContext.createMediaStreamSource(stream);

6

7

8 const analyser = audioContext.createAnalyser();

9

10

11 analyser.fftSize = 2 ** 10;

12 const bufferLength = analyser.frequencyBinCount;

13 const dataArray = new Uint8Array(bufferLength);

14

15

16 source.connect(analyser);

17 analyser.connect(audioContext.destination);

18 })

19 .catch((error) => {

20 console.error('Error accessing microphone:', error);

21 });

在这段代码中,我们设置了 AnalyserNode 的 fftSize 属性,该属性决定了在进行频谱分析时使用的数据点数量。我们还创建了一个 Uint8Array 数组用于存储分析后的音频数据。

3.4 初始化数组以存储分析后的音频数据

Uint8Array 的创建和作用

为了在后续的可视化中使用音频数据,我们需要初始化一个数组来存储分析后的数据。这里我们使用 Uint8Array,它是一个包含 8 位无符号整数的数组,适用于表示音频数据的振幅。

1

2requestMicrophonePermission()

3 .then((stream) => {

4

5 const source = audioContext.createMediaStreamSource(stream);

6

7

8 const analyser = audioContext.createAnalyser();

9

10

11 analyser.fftSize = 2 ** 10;

12 const bufferLength = analyser.frequencyBinCount;

13 const dataArray = new Uint8Array(bufferLength);

14

15

16 source.connect(analyser);

17 analyser.connect(audioContext.destination);

18 })

19 .catch((error) => {

20 console.error('Error accessing microphone:', error);

21 });

在上述代码中,bufferLength 表示 AnalyserNode 分析频率的数量。我们使用这个长度来初始化 Uint8Array,以确保它有足够的空间来存储我们的音频数据。

至此,我们已经完成了获取音频数据的准备工作,接下来我们将在实时音频可视化部分深入探讨如何利用这些数据进行绘图。

4. 实时音频可视化

在这一部分,我们将详细介绍如何创建一个实时音频可视化效果。我们将使用 requestAnimationFrame 来实现动画循环,利用 AnalyserNode 的 getByteFrequencyData 方法获取音频数据,并使用 Canvas 绘制频谱图。

4.1 创建动画循环,以实现实时更新画布

requestAnimationFrame 的使用

为了实现实时更新画布,我们将使用浏览器提供的 requestAnimationFrame 方法。这个方法会告诉浏览器你想要执行动画,并在下一次重绘之前调用指定的函数,通常是递归调用自身。

1

2function draw() {

3 requestAnimationFrame(draw);

4

5

6}

7

8

9draw();

上述代码中,我们创建了一个 draw 函数,并在其中递归调用 requestAnimationFrame(draw),以实现连续的画布更新。

4.2 获取音频数据并更新数组

AnalyserNode 的 getByteFrequencyData 方法

在动画循环中,我们需要获取音频数据并更新之前初始化的数组。这里我们使用 AnalyserNode 的 getByteFrequencyData 方法来获取频率数据,并将其存储在我们的 dataArray 数组中。

1

2function draw() {

3 requestAnimationFrame(draw);

4

5

6 analyser.getByteFrequencyData(dataArray);

7

8

9}

getByteFrequencyData 方法会将当前音频频域数据拷贝到传入的 Uint8Array 中,我们的 dataArray 数组将被更新以反映当前音频的频谱数据。

4.3 使用 Canvas 绘制频谱图

Canvas 渲染和绘制频谱图

现在我们已经获取了更新后的音频数据,接下来我们将使用 Canvas 来绘制频谱图。在 Canvas 上进行绘制通常涉及到 getContext 方法、路径设置、样式设置等步骤。

1

2function draw() {

3 requestAnimationFrame(draw);

4

5

6 analyser.getByteFrequencyData(dataArray);

7

8

9 ctx.clearRect(0, 0, canvas.width, canvas.height);

10

11

12 ctx.fillStyle = "#282828";

13

14

15 const len = dataArray.length;

16 const barWidth = canvas.width / len;

17

18 for (let i = 0; i < len; i++) {

19 const data = dataArray[i];

20 const barHeight = (data / 2 ** 9) * canvas.height;

21 const x = i * barWidth;

22 const y = canvas.height - barHeight;

23

24

25 ctx.fillRect(x, y, barWidth, barHeight);

26 }

27}

上述代码中,我们首先使用 clearRect 方法清空画布,然后设置了矩形的填充样式。接着,我们使用 fillRect 方法在 Canvas 上绘制频谱图。通过循环遍历 dataArray,我们计算每个频率对应的矩形的位置和高度,并使用 fillRect 绘制。

至此,我们已经完成了实时音频可视化的主要部分。在下一部分,我们将讨论如何对代码进行进一步的优化和扩展,以及如何添加一些交互性的功能。

5. 优化与扩展

在这一部分,我们将讨论如何对我们的实时音频可视化应用进行优化,以提高性能,并探讨如何扩展应用的功能。

5.1 介绍可能的优化策略,以提高性能

如何优化频谱图的性能

实时音频可视化应用可能会面临性能方面的挑战,特别是在处理大量数据并实时更新画布的情况下。以下是一些可能的优化策略:

- 降低

fftSize的值:AnalyserNode的fftSize决定了在进行频谱分析时使用的数据点数量。减小这个值可以减轻性能压力,但也可能导致频谱图的分辨率下降。

1analyser.fftSize = 2 ** 9;

- 限制绘制频率: 不必每一帧都更新画布,可以通过限制绘制的频率来减轻性能压力。例如,每隔几帧才更新一次画布。

1let frameCount = 0;

2

3function draw() {

4 frameCount++;

5

6 if (frameCount % 2 === 0) {

7 requestAnimationFrame(draw);

8 return;

9 }

10

11

12 analyser.getByteFrequencyData(dataArray);

13

14

15 ctx.clearRect(0, 0, canvas.width, canvas.height);

16

17

18

19

20 requestAnimationFrame(draw);

21}

22

23

24draw();

- 使用缓存: 对于相对稳定的可视化效果,可以考虑使用缓存,避免不必要的重复计算。

1

2analyser.getByteFrequencyData(dataArray);

3

4

5ctx.clearRect(0, 0, canvas.width, canvas.height);

6

7

8

9

10requestAnimationFrame(draw);

这些建议都是基于实际应用需求和性能要求的折中。在实际开发中,可以根据具体情况进行调整。

5.2 探讨如何扩展功能

添加音频控制按钮或改变可视化效果的思考

为了使应用更具吸引力和互动性,我们可以考虑扩展应用的功能。以下是一些可能的扩展思路:

- 音频控制按钮: 添加播放/暂停、音量控制等按钮,使用户能够更灵活地控制音频的播放。

1

2const playButton = document.getElementById("playButton");

3

4playButton.addEventListener("click", () => {

5 if (audioContext.state === "suspended") {

6 audioContext.resume();

7 }

8

9 if (audioContext.state === "running") {

10 audioContext.suspend();

11 }

12});

- 改变可视化效果: 提供用户切换不同可视化效果的选项,例如切换为波形图、频谱图等。

1

2const visualizationSelect = document.getElementById("visualizationSelect");

3

4visualizationSelect.addEventListener("change", () => {

5 const selectedValue = visualizationSelect.value;

6

7

8 switch (selectedValue) {

9 case "spectrum":

10

11

12 break;

13 case "waveform":

14

15

16 break;

17

18 }

19});

这些扩展功能可以通过添加一些 HTML 元素和事件监听器,以及相应的逻辑实现。通过使应用更加交互和多样化,可以提高用户体验。

在实际开发中,还可以考虑加入更多的可配置项、音频特效等功能,以满足不同用户的需求。扩展功能的设计需要根据应用的定位和用户群体来决定,以实现更好的用户体验和吸引力。

6. Conclusion

6.1 总结所用到的关键知识点

在这篇技术分享中,我们深入探讨了如何使用 Web Audio API 创建一个实时音频可视化应用。关键知识点包括:

-

Web Audio API 简介: 了解了 Web Audio API 提供的功能,以及其在处理和分析音频数据方面的应用。

-

Canvas 绘图: 学习了如何使用 Canvas 绘制频谱图,通过获取音频数据并实时更新画布,实现了音频可视化效果。

-

getUserMedia: 使用了

navigator.mediaDevices.getUserMedia方法获取用户的麦克风权限,以便从麦克风获取音频流数据。 -

优化与扩展: 探讨了一些优化策略,以提高应用的性能,同时讨论了如何扩展应用的功能,添加交互性和多样性。

6.2 提供读者自行尝试的建议和资源链接

为了进一步深入学习和尝试,建议读者探索以下方向:

-

更多 Web Audio API 特性: Web Audio API 提供了丰富的特性,包括各种音频节点类型、音频特效等。阅读 Web Audio API 文档 可以深入了解更多内容。

-

Three.js 与音频可视化: 如果你对创建更复杂的音频可视化效果感兴趣,可以尝试结合 Three.js 这样的 3D 渲染库,创建更炫酷的可视化效果。阅读 Three.js 文档 可以帮助你入门。

-

更多优化策略: 阅读关于前端性能优化的文章,了解如何更好地优化频谱图的性能。Google Developers - Web Performance 提供了很多优化的建议。

7. 人声与傅里叶变换的深入解析

在音频处理的背景下,傅里叶变换是一项强大的数学工具,它提供了深入解析声音的频域特征的手段。对于理解人声和音频可视化,深入研究傅里叶变换对于揭示声音背后的数学关系至关重要。

7.1 时域与频域的转换

人声的产生是由声带振动引起的空气压力波动。这种声音信号可以在时域(时间轴上)表示为波形图。然而,傅里叶变换允许我们将这个时域的波形转换为频域表示,即不同频率成分的振幅。

傅里叶变换的数学表达式为:

[X(f) = \int_{-\infty}^{\infty} x(t) \cdot e^{-j2\pi ft} ,dt]

其中,(X(f)) 是频率为 (f) 的复数振幅,(x(t)) 是时域的信号,(j) 是虚数单位。这个变换将时域信号转换为频域信号,显示了信号中包含的不同频率成分。

7.2 频域分析与声音的分解

在音频可视化中,我们通常使用离散傅里叶变换(Discrete Fourier Transform,DFT)或快速傅里叶变换(Fast Fourier Transform,FFT)来处理离散的音频数据。这允许我们对声音进行频域分析,将其分解为一系列频率、幅度和相位。

人声中的元音和辅音以及不同音调的变化,都反映在频域上的特定频率成分。通过分析频谱图,我们能够看到频率分量的强弱、声音的音高,甚至可以识别音调的变化。这种分解为频域成分的过程使得我们可以以数学模型的形式更深入地理解和表达声音。

7.3 频谱图与数值化的声音

在实际的音频可视化应用中,频谱图呈现了声音在频域上的分布。频谱图的横轴表示频率,纵轴表示振幅。峰值和波形的形状反映了声音的频率构成和强度。这些数值化的数据使得我们能够以更直观的方式理解和分析声音,而不仅仅局限于听觉上的感知。

通过深入理解人声与傅里叶变换之间的关系,我们能够更好地利用数学工具,以更丰富的方式呈现和解释声音。这种深入底层的分析有助于提升对音频可视化的认识,使得我们能够更准确地捕捉和表达声音的特性。

8. 参考资料

8.1 Web Audio API 文档

8.2 MDN Web Docs 相关文章

8.3 其他相关资源链接

这些资源将帮助读者进一步学习和探索 Web Audio API 及相关的前端开发技术。希望读者能够在实践中深化对音频可视化和前端开发的理解。